人工智能模型的复杂性正在爆炸,因为它们接受了下一级的挑战,如对话式人工智能。训练他们需要强大的计算能力和可扩展性。 具有张量浮点(TF32)的NVIDIA A100张量内核提供了比NVIDIA Volta高20倍的性能,代码变化为零,自动混合精度和FP16的性能提高了2倍。当与NVIDIA NVLink、NVIDIA NVSwitch、PCI Gen4、NVIDIA InfiniBand和NVIDIA Magnum IO SDK结合使用时,可以扩展到数千个A100 GPUs。 像BERT这样的训练工作量可以通过2,048个A100 GPUs在不到一分钟的时间内大规模解决,这是解决时间的世界纪录。 对于像深度学习推荐模型(DLRM)这样具有大规模数据表的模型,100 80GB的每个节点可达到1.3 TB的统一内存,并提供比100 40GB高达3倍的吞吐量。 NVIDIA在MLPerf中的地位,在AI训练的行业基准中创下了多项性能记录。

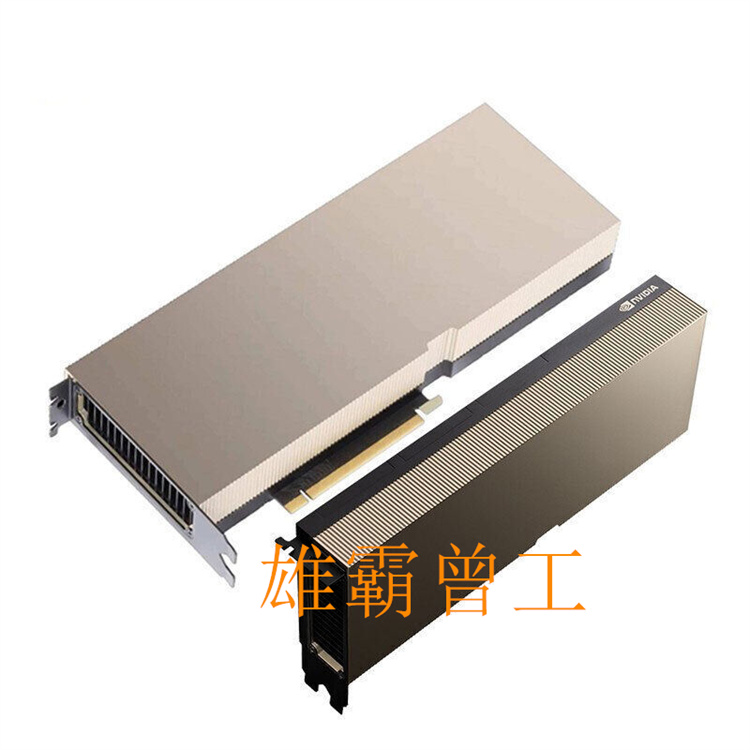

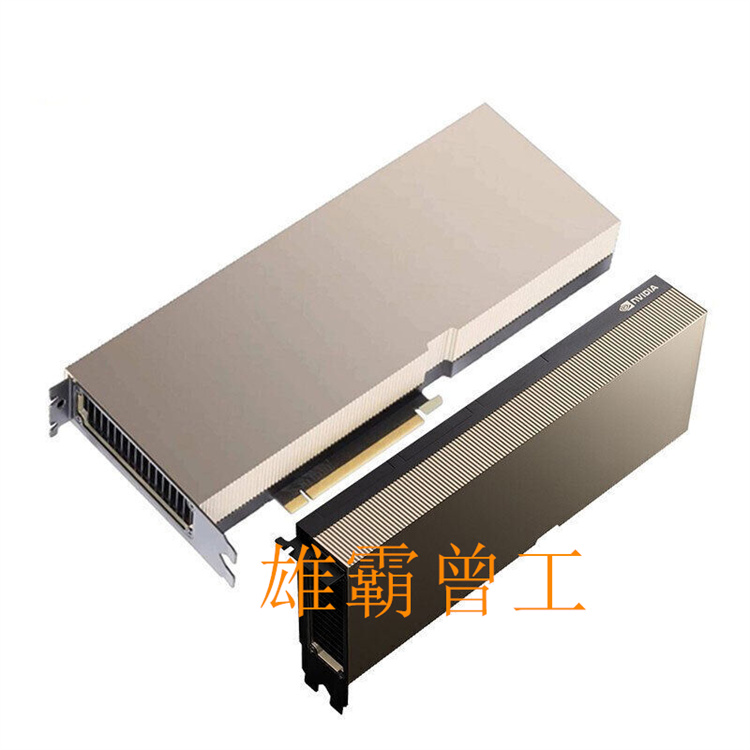

A800 PCIE 单卡A800 NVLink 8卡模组

A100 超微NV服务器

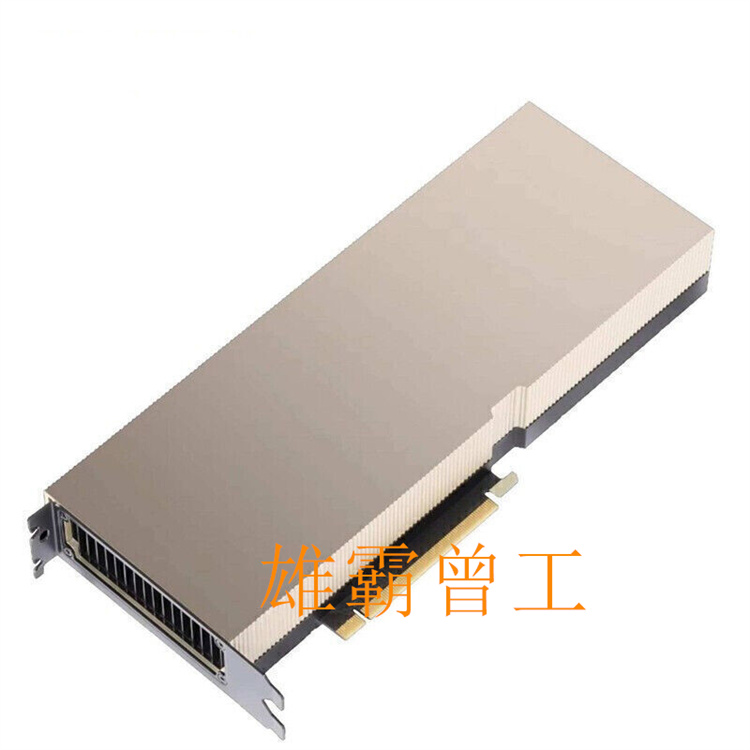

A100 PCIE 单卡

H800超微NV服务器

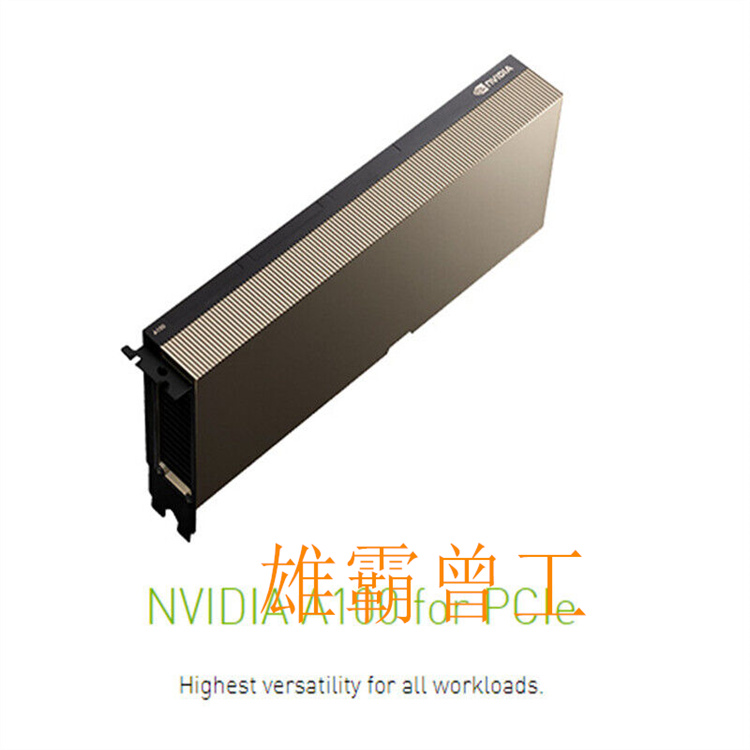

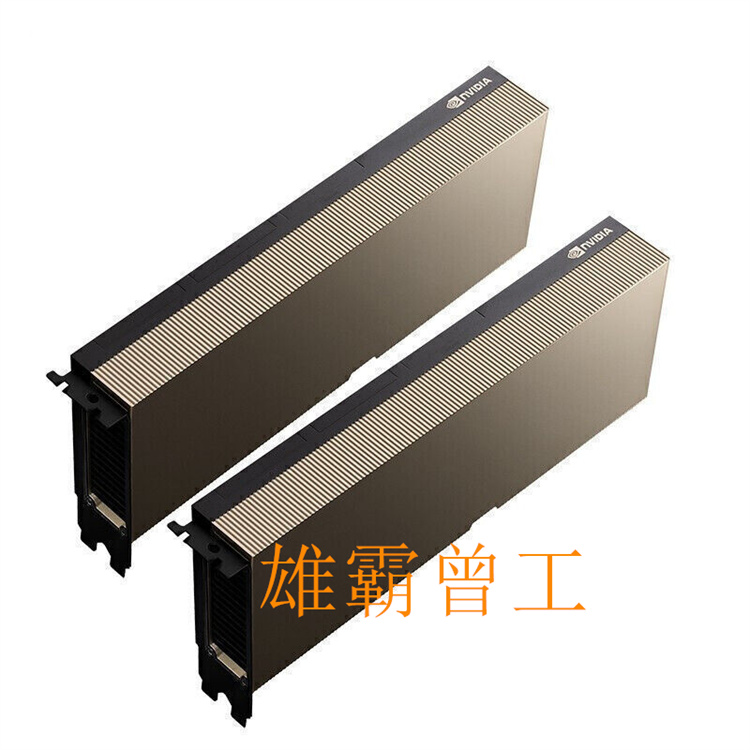

H100 PCIE 单卡

H100 超微NV服务器

GH200 超级服务器

客服1

客服1